简介

Ollama 是一个轻量级、可扩展的框架,旨在帮助用户在本地机器上构建和运行大型语言模型。它提供了一个简单的 API 用于创建、运行和管理模型,并附带了一个预建模型库,这些模型可以轻松地应用于各种应用程序中。

系统要求

在开始之前,请确保你的系统满足以下要求:

至少 8 GB 的 内存来运行 7B 模型

16 GB 的 内存 来运行 13B 模型

32 GB 的 内存 来运行 33B 模型

无需GPU要求,能跑起来,可以玩玩

安装步骤

macOS 和 Windows

对于 macOS 和 Windows 用户,可以直接从 Ollama GitHub 页面 下载预构建的安装程序。

Linux

Linux 用户可以通过运行以下命令来安装 Ollama:

curl -fsSL https://ollama.com/install.sh | sh

Docker

如果你更喜欢使用 Docker,可以从 Docker Hub 获取官方的 Ollama Docker 镜像:

ollama/ollama

快速开始

安装完成后,你可以通过以下命令运行并和 Llama 3 模型进行对话:

ollama run llama3

模型库

Ollama 支持多种模型,你可以从 ollama.com/library 下载所需的模型。以下是一些示例模型及其参数和大小:

Model

Parameters

Size

Download

Llama 3

8B

4.7GB

ollama run llama3

Llama 3

70B

40GB

ollama run llama3:70b

Mistral

7B

4.1GB

ollama run mistral

Dolphin Phi

2.7B

1.6GB

ollama run dolphin-phi

Phi-2

2.7B

1.7GB

ollama run phi

Neural Chat

7B

4.1GB

ollama run neural-chat

Starling

7B

4.1GB

ollama run starling-lm

Code Llama

7B

3.8GB

ollama run codellama

Llama 2 Uncensored

7B

3.8GB

ollama run llama2-uncensored

Llama 2 13B

13B

7.3GB

ollama run llama2:13b

Llama 2 70B

70B

39GB

ollama run llama2:70b

Orca Mini

3B

1.9GB

ollama run orca-mini

LLaVA

7B

4.5GB

ollama run llava

Gemma

2B

1.4GB

ollama run gemma:2b

Gemma

7B

4.8GB

ollama run gemma:7b

Solar

10.7B

6.1GB

ollama run solar

实践开始安装Llama 3

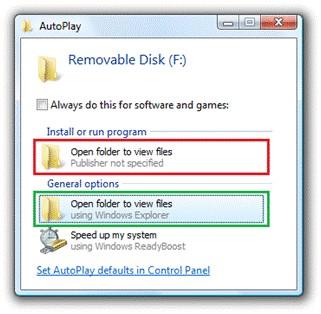

1.下载Ollama

2.下载和运行llama3

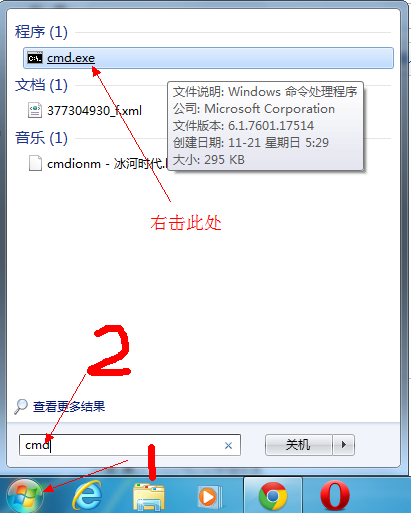

打开命令窗口cmd

ollama run llama3

首次需要等会下载模型文件到本地,然后就可以输入对话:

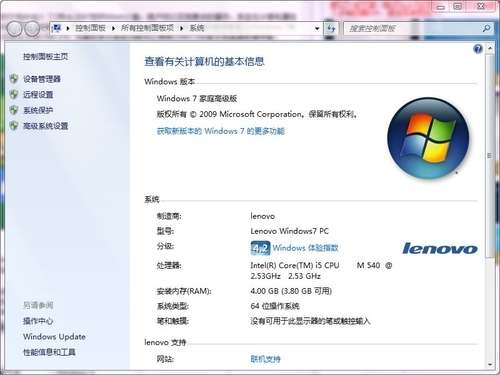

我的笔记本配置很一般,好多年的,也能跑起来,回答速度还算可以接收

结语

Ollama 提供了一个强大而灵活的平台,用于在本地运行大型语言模型。无论是研究人员、开发者还是普通用户,都可以利用这个工具来探索和实现各种语言处理任务。通过上述步骤,你可以轻松地在你的机器上安装和运行大型语言模型,开启你的 AI 之旅。

用户评论

这个游戏太快了,10分钟能装完,真是节省时间啊。

有13位网友表示赞同!

笔记本上玩Llama 3,看来不需要大配置呢。

有19位网友表示赞同!

刚安装完就迫不及待想玩游戏了。

有18位网友表示赞同!

太方便了,不需要重启电脑就直接玩。

有15位网友表示赞同!

感觉这游戏挺小巧的,适合学生党用笔记本。

有19位网友表示赞同!

这么快就能开始玩新游戏了,好开心。

有19位网友表示赞同!

10分钟装完成功,现在试试看游戏效果如何。

有9位网友表示赞同!

笔记本上能安装大型游戏真是越来越好用了。

有10位网友表示赞同!

第一次听说可以在10分钟内安装游戏呢。

有16位网友表示赞同!

游戏界面简洁,看起来很清爽呀。

有5位网友表示赞同!

这速度简直是神器!

有5位网友表示赞同!

我之前担心笔记本配置低,现在可以放心了。

有15位网友表示赞同!

感觉Llama 3很适合当作休闲游戏来玩。

有15位网友表示赞同!